SqueezeNet与模型压缩

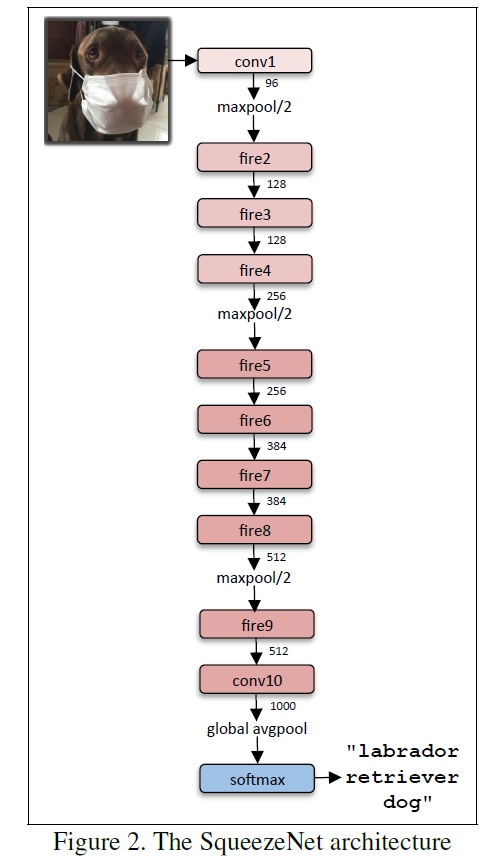

基础模块是fire,由(\(s_1\)个1x1卷积)接上( \(e_1\)个1x1卷积+\(e_3\)个3x3卷积)。

第一层是卷积层,输出Channel=96,之后接fire模块。在1、4、8层插入max pooling以减小图像尺寸。

最后接个输出channel=1000的卷积层,followed by softmax。

SqueezeNet的优势在于参数少,模型大小只有5MB,在使用deep compresion之后,更是压缩到0.5MB。分类精度与AlexNet相当。

squeezeNet

关于deep compresion

主要有三种手段: 量化,裁剪,编码。 此外,作者还发现,使用裁剪之后的模型为初始值,再次训练,正确率还会提升。 模型压缩相当于一种正则化。这种方法称为dense-sparse-dense(DSD)。

先记录这么多,细节再慢慢看论文补吧。

参考文献

[1] SqueezeNet https://arxiv.org/pdf/1602.07360.pdf [2] Deep Compression https://arxiv.org/abs/1510.00149